Pourquoi un produit chimique est autorisé ? Pour son utilité, après évaluation drastique de sa sécurité ? C’est un doux rêve : l’utilité est présupposée mais jamais questionnée quant à la sécurité elle n’est évaluée que partiellement, sur la base des données fournies par les industriels sur un ensemble très limité de dommages. Les travaux en toxicologie, épidémiologie, sociologie ou histoire montrent sans ambiguïté possible les limites importantes de la réglementation des produits chimiques.

Pour qu’un pesticide soit autorisé, un ou plusieurs fabricants doivent en faire la demande. Pour cela, le fabricant soumet un dossier composé de nombreuses études réglementaires effectuées selon des protocoles bien établis. L’agence s’appuie donc principalement sur les données fournies par le fabricant, ce qui pose problème puisqu’il a un intérêt évident à l’autorisation du produit. Néanmoins les agences doivent également prendre en compte ce qui est connu dans la littérature scientifique sur le pesticide à autoriser. Bien entendu, ce n’est possible que si le pesticide existe déjà (dans le cas d’une ré-autorisation, par exemple).

Or tout ce processus est critiqué par une littérature abondante. L’expertise collective de l’Inrae et de l’Ifremer sur l’impact des pesticides sur la biodiversité (ensuite simplement appelée Esco) le formule ainsi : « Les insuffisances du dispositif ont suscité une littérature beaucoup plus abondante que ses améliorations ou succès » et ceci que ce soit par rapport aux effets des pesticides sur la biodiversité ou sur la santé humaine. Lors de la remise de l’expertise collective de l’Inserm en 2021 sur les effets des pesticides sur la santé humaine, le sociologue Jean-Noël Jouzel déclarait qu’il y avait une séparation croissante entre la toxicologie réglementaire et la recherche académique en toxicologie.

Les agences réglementaires sont souvent critiquées pour les conflits d’intérêt de certains de leurs experts. Néanmoins, le sociologue François Dedieu affirme clairement qu’une telle critique favorise les intérêts des firmes industrielles ou des agences puisque pendant ce temps le processus de régulation lui même n’est pas remis en question1. Or même si la question des conflits d’intérêts était complètement résolue dans les agences réglementaires, la régulation des pesticides reste problématique… comme nous allons le voir.

Les agences s’appuient sur des études réglementaires parfois de piètre qualité

Comme je l’avais signalé, une chercheuse et un chercheur ont pu se pencher sur les études réglementaires soumises à l’agence brésilienne. Leur constat était relativement simple : aucune étude réglementaire n’identifiait d’effet cancérigène, génotoxique ou tératogène. À l’inverse, en allant consulter les études dans la littérature scientifique, 80% des études identifiaient un tel effet. Le hiatus est frappant et en se concentrant prioritairement sur les études réglementaires, les agences vont avoir tendance à sous-estimer les effets des pesticides.

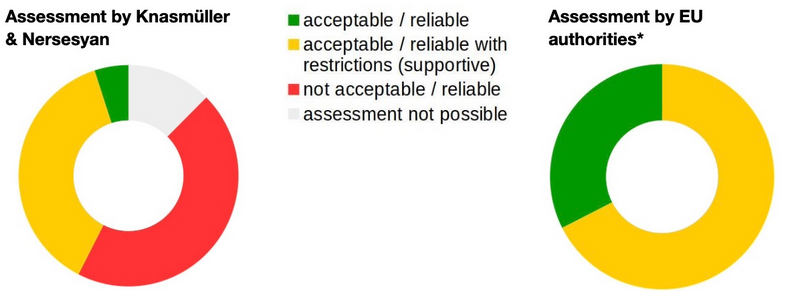

En Europe, aucune équipe de recherche n’a réussi à ma connaissance à obtenir les études réglementaires comme l’a fait l’équipe brésilienne. Pour autant, par décision de justice, l’ONG SumOfUs a pu accéder aux études réglementaires sur le glyphosate. Elle les a soumis à deux toxicologues, dont l’un d’eux a été payé par l’ONG. Leur analyse est sanglante : la majorité des études soumises (34 sur 53) était considérée comme non fiables.

D’ailleurs, pour le philosophe des sciences Kevin Elliott, les études de l’industrie devraient être jugées moins objectives que les études de la littérature scientifique si elles ne sont pas accessibles et donc pas critiquables par toute personne compétente. Pourtant, les agences agissent à l’inverse, en considérant généralement plus fiables les études confidentielles de l’industrie, qui suivent les « bonnes pratiques de laboratoire » (dont j’ai déjà parlé dans un article précédent et sur Twitter).

Une prise en compte de la littérature très partielle

Ainsi, la littérature scientifique est très peu prise en compte par les agences, de nombreux articles étant jugés non fiables, leurs résultats n’ont aucun poids dans la décision finale. C’est comme si dans un procès on écoutait principalement les arguments d’une seule des deux parties.

Pour illustrer cela, la Commission nationale Déontologie et Alertes en santé publique et environnement reprend à son compte les chiffres de l’ONG Générations Futures concernant l’évaluation du glyphosate par l’EFSA : « de l’ordre de 90 % des articles publiés dans la littérature scientifique auraient été éliminés car jugés « non pertinents » », justement parce qu’ils ne respectent pas les bonnes pratiques de laboratoire… que les études académiques n’ont pourtant pas à respecter !

La toxicologue, Laurence Huc, elle aussi approuve le fait que les agences réglementaires ne prennent pas suffisamment en compte la littérature scientifique. Ce n’est pas son seul avis car elle écrit la même chose dans un article co-écrit avec le sociologue Jean-Noël Jouzel, dans lequel ils pointent « un hiatus permanent entre « savoir réglementaire » et « science académique » dans la procéduralisation de l’évaluation des risques », ce qui est souligné « dans de nombreux travaux de sciences sociales ». On retrouve également le même type d’affirmation dans l’Esco, où elle mentionne « les contraintes qui conduisent à écarter du processus décisionnel une partie des connaissances scientifiques pourtant disponibles dans le champ académique », elle indique aussi que la bibliographie est « très partiellement mobilisée » par les agences « de nombreuses connaissances disponibles ne sont pas mobilisées pour évaluer a priori les risques associés à l’utilisation des PPP [produits de protection des plantes, les pesticides donc] ».

Dans le cas du bisphénol A, les agences ont fini par prendre en compte des études de la littérature scientifique qui étaient sur de petits échantillons. Auparavant elles les rejetaient simplement. La conséquence : la dose acceptable d’exposition au bisphénol A a été divisée par… 100 000. On voit l’effet que peut avoir la prise en compte d’études auparavant ignorées. Pour autant, les agences ne vont pas encore jusqu’à appliquer cela aux autres bisphénols, dont on sait pourtant qu’ils sont chimiquement proches et risquent fort d’avoir les mêmes conséquences sur la santé2).

Une caractérisation parcellaire de la cancérogénicité

Savoir si un pesticide est cancérigène est crucial. Pour des questions de santé publique, bien entendu, mais également pour des questions réglementaires car un pesticide cancérigène doit être interdit d’après le règlement européen. Cette étape de caractérisation du danger cancérigène est donc fondamentale et c’est notamment cela qui explique l’importante polémique autour de la cancérogénicité du glyphosate.

Historiquement l’idée d’interdire les substances cancérigènes date des années 50, notamment avec les propositions de Godersberg en 1954 ensuite reprises par l’Union Internationale contre le Cancer ainsi que nous le rappellent les sociologues et historienne Boudia et Jas. Or, si cette interdiction est valable (sous certaines conditions) en Europe, ce n’est plus le cas aux USA, bien que l’EPA était sur cette longueur d’onde dans les années 1970. L’organisme étatsunien pour la santé au travail OSHA a été enjoint par la justice de ne plus interdire l’exposition aux substances cancérigènes mais d’effectuer une évaluation probabiliste. Cela illustre que la réglementation des pesticides n’est évidemment pas qu’une question scientifique, mais également une question politique.

Laurence Huc et le toxicologue Robert Barouki rappellent qu’il existe de nombreux mécanismes de cancérogénicité, connus depuis plusieurs dizaines d’années. Or, indiquent-ils, les agences ne s’intéressent qu’à un seul de ces mécanismes : la génotoxicité.

À titre d’exemple, Huc et Jouzel prennent les fongicides SDHI qui sont autorisés depuis plusieurs années alors qu’ils provoquent des tumeurs chez les rongeurs. Mais le mécanisme de cancérogénicité n’étant pas la génotoxicité, celui-ci n’est pas pris en compte par les agences. Pour elles, rien ne vient expliquer une éventuelle cancérogénicité, c’est donc que les SDHI ne sont pas cancérigènes !

C’est aussi ce que soupçonnent certains auteurs sur le glyphosate : que le mécanisme de cancérogénicité impliquerait une disruption endocrinienne ou du microbiome. Néanmoins le Centre International de la Recherche sur le Cancer considère le glyphosate génotoxique, ce que rejettent les agences réglementaires.

Une prise en compte des perturbateurs endocriniens restrictive et tardive

Bien que les perturbateurs endocriniens (PE) soient définis par l’OMS depuis 2000. Il a fallu attendre 17 années de plus pour que l’UE sorte une définition… très proche. Or tant qu’il n’y avait pas de définition européenne… il n’y avait pas de moyen de les contrôler. Ils n’existaient pas. Désormais la définition existe et nécessite un lien causal. S’il semble rigoureux de demander l’identification d’un tel lien pour classer une substance comme perturbatrice endocrinienne, il est en réalité très difficile de mettre en évidence une telle causalité. Cette définition aura pour effet de retarder la prise en compte de perturbateurs endocriniens, et leur régulation adéquate. Huc et Barouki recommandent donc de considérer également les perturbateurs endocriniens suspectés ou présumés3.

La situation n’est pas plus enviable aux États-Unis d’Amérique où, miraculeusement, aucune des substances testées n’a été identifiée comme un perturbateur endocrinien.

Les effets cocktails trop peu considérés

L’effet cocktail est le principe selon lequel l’exposition à un mélange de plusieurs substances peut avoir plus d’effet que la substance seule ou même que la somme des effets de chacune des substances prises isolément.

Rémy Slama, épidémiologiste à l’Inserm, utilise une élégante image pour faire comprendre cela : on a des tas de sable qui pèsent autant que des tas de pierres.

Le problème est que les agences raisonnent substance par substance et ne prennent pas en compte l’effet de l’exposition conjointe à plusieurs substances. Or, pour prendre l’exemple des pesticides, l’EFSA nous informe qu’en 2020 41,9% des échantillons d’aliments conventionnels testés présentaient des résidus de pesticides, dans leur grande majorité sous les seuils réglementaires. C’est-à-dire qu’en mangeant 5 aliments différents, on est quasiment certain (93%) d’être exposé à au moins un résidu de pesticide et probablement plusieurs, sans compter les résidus présents dans l’air ou dans l’eau. Pourtant les effets de ces expositions ne sont pas évalués et ne rentrent pas en ligne de compte pour l’autorisation des produits.

Le projet EDC-MixRisk, financé par l’Union Européenne, considère que la réglementation actuelle sous-estime « systématiquement » les risques liés à l’exposition combinée à des perturbateurs endocriniens (qu’ils soient suspectés ou avérés). L’approche actuelle qui étudie chaque composant indépendamment peut sous-estimer les risques d’un facteur 1 à 100, selon le produit, dans les situations étudiées par le projet4.

Pour autant, Huc et Barouki nous disent que l’effet cocktail est pris en compte depuis plus de 30 ans pour les PCB ou les dioxines, où il faut « additionner les doses » pour les substances similaires. Mais ce sont des exceptions. Rien de tel, par exemple, pour les bisphénols dont je parlais précédemment.

De même, dans un avis récent, l’Anses reconnaît qu’il faut additionner les doses de nitrates et nitrites et non pas les considérer indépendamment. Ce sont des exemples allant dans le bon sens, mais malheureusement ils font beaucoup trop figure d’exception.

Des effets sublétaux « insuffisamment évalués »

L’Esco l’a affirmé sans détour : « Les effets sublétaux sont insuffisamment évalués notamment en ce qui concerne les perturbations, qui peuvent avoir des répercussions sur la valeur sélective des espèces et leurs rôles dans les écosystèmes ».

Sgolastra et collègues disent également que l’évaluation de la sublétalité est un trou dans la raquette de l’évaluation des risques. Dans le cas des abeilles, elle est d’ailleurs particulièrement délicate à mener car les ruches peuvent compenser certains déficits, les tests sont de courte durée, les abeilles butinent sur de grandes surfaces et donc les groupes contrôle et expérimentaux des études de plein champ se retrouvent dans des conditions finalement assez peu différentes.

Demortain souligne néanmoins que le cas des néonicotinoïdes fait figure d’exception puisque, pour une fois, ce sont des données de sublétalité (a fortiori produites dans le secteur académique) qui ont conduit à l’interdiction de ces insecticides.

Siviter et Muth avertissent qu’il est nécessaire de changer la réglementation sans quoi d’autres insecticides aux modes d’action proche (ils prennent l’exemple du flupyradifurone et le sulfoxaflor, autorisés par l’EFSA) pourraient être autorisés et ayant les mêmes conséquences dommageables pour la biodiversité. Ils appellent donc à ce que les effets sublétaux des insecticides soient obligatoirement évalués sur les abeilles sauvages, mais également sur d’autres types d’insectes.

Une écotoxicité peu prise en compte

Au-delà des effets sur les mammifères en général et sur les humains en particulier, les effets sur les autres organismes vivants sont encore moins bien évalués, et donc moins bien pris en compte par les agences réglementaires.

Kleinman et Suryanarayanan ont étudié les lacunes des agences susceptibles d’expliquer que des substances nocives pour les abeilles aient pu être autorisées. Ils relèvent que pendant longtemps les effets néfastes des pesticides sur les insectes n’étaient tout simplement pas pris en compte car ces espèces étaient vues comme devant être éliminées. À l’heure actuelle, l’Esco souligne que seul un nombre limité d’espèces est pris en compte. Ce sont surtout les effets sur les espèces qui peuvent être élevées en laboratoire qui sont étudiés. De plus, l’Esco indique que les tests ne reflètent pas la réalité de l’exposition des espèces dans leur environnement (des expositions répétées pendant de longues périodes).

Il peut sembler étonnant que des agences aient ignoré les effets sur un spectre aussi vaste du vivant. Kleinman et Suryanarayanan soulignent que l’EPA se satisfaisait de cette ignorance car l’étude d’effets fins sur les insectes (comme des effets sublétaux ou chroniques) est complexe et l’agence n’en avait pas les moyens. Dans ce contexte, les chercheurs indiquent que Bayer n’a même pas besoin de frauder les tests réglementaires pour voir ses substances autorisées, il suffit juste de s’appuyer sur l’ignorance que produisent les agences. En plus de cela, Bayer contribue à cette ignorance en menant des études en plein champ qui ne montrent aucun effet pour la simple raison que ces études ne permettent pas d’identifier des effets (la parcelle étudiée est bien plus petite que le périmètre d’action des abeilles). Bayer possède ensuite les moyens de diffuser de tels résultats à travers divers événements aux apparences scientifiques (comme des conférences, des publications dans des journaux spécialisés, etc).

D’autre part Kleinman et Suryanarayanan notent que les connaissances apportées par les apiculteurs sont le plus souvent ignorées car elles ne correspondent pas au canon attendu par les agences (elles ne suivent évidemment pas les bonnes pratiques de laboratoire, qui ne sont pas faites pour cela, mais auxquelles les agences sont accrocs) mais également car elles abordent des aspects habituellement ignorés par les agences (sublétalité, effet cocktail).

Par construction des seuils souvent sur-estimés

En conséquence de toute ces lacunes dans l’évaluation des risques, les seuils calculés par les agences réglementaires ne peuvent pas être considérés comme des seuils de sûreté. Aussi, les personnes qui affirment qu’il n’y a rien à craindre vis-à-vis de telle substance puisque sa présence est inférieure au seuil réglementaire commettent une faute logique.

D’autre part, les effets chroniques des produits chimiques peuvent mettre du temps à se matérialiser. Il en faut donc encore plus pour les caractériser. Pendant ce temps, les agences auront beau jeu d’affirmer qu’aucune preuve scientifique ne permet de douter des seuils qu’elles ont décrétés. Actuellement, nous en avons un exemple avec le glyphosate. Plusieurs instances scientifiques renommées suspectent sa cancérogénicité. Pourtant les agences réglementaires n’ont pas revu à la baisse les seuils admissibles. De même, il a fallu de nombreuses années avant que le seuil d’exposition au bisphénol A soit (drastiquement) revu à la baisse. En attendant, ils sont donc sur-estimés.

De plus, les agences appliquent des « facteurs de sécurité » entre le seuil auquel des effets sont observés chez certains animaux (des rongeurs en général) et le seuil considéré admissible pour l’humain. Généralement ce facteur de sécurité est de 100. C’est en réalité du doigt mouillé. Pourquoi ce facteur de sécurité pour passer d’une espèce à une autre est de 100 ? Pourquoi pas 10 ou 10 000 ? L’Esco souligne également que ces facteurs ne prennent pas en compte la diversité des espèces, ni les interactions entre elles5.

L’idée même de seuil est contestée comme l’indique l’épidémiologiste Rémy Slama dans sa leçon inaugurale au Collège de France. Il faut de plus distinguer différents seuils qui dépendent également des stades de développement des individus.

Dans certains domaines, comme avec les nanoparticules, la « surface de réaction » semble bien plus pertinente pour identifier les risques associés plutôt que la masse de substance, comme le rappellent les sociologues et historienne Boudia et Jas.

La protection magique des équipements de protection

Malgré la sur-estimation probable des seuils, il arrive que des pesticides soient trop risqués pour être utilisés par des agriculteurs. Dans une telle situation, les agences ont une recette miracle : recommander l’utilisation d’équipements de protection. Les agences considèrent que ces équipements offrent magiquement une protection de 90% à 95%, comme le documente une longue enquête de la journaliste Stéphane Horel.

De plus, l’EFSA continue à ne pas prendre en compte les données de PestExpo, qui montrent à la fois une exposition plus importante qu’imaginé notamment parce que les équipements de protection… ne protègent pas forcément. Une raison à cela est que l’EFSA s’appuie sur les bonnes pratiques agricoles. En vertu de celle-ci, l’EFSA ignore les données correspondant à ce qu’elles considèrent comme des « conduites incorrectes » ou les « mauvais comportements ». Un peu comme si pour évaluer un équipement de sécurité dans une voiture, on partait du principe que tout le monde respectait parfaitement le code de la route.

Comme le souligne Dedieu, les agences s’appuient sur des modèles simplistes pour calculer l’exposition des agriculteurs. Mais les agences se situent dans une sorte d’irréfutabilité : comme il n’y a pas de contrôle que les modélisations reflètent la réalité sur le terrain et que les agriculteurs restent assez secrets sur leur utilisation des pesticides, il n’y a que peu de possibilité que ces modèles soient remis en cause. Ainsi que le dit Dedieu : « Les scénarios d’exposition sont robustes parce qu’ils ne sont jamais remis en cause »6. Pour Dedieu, il y a une sorte d’accord tacite (un déni organisé) entre les agences d’une part et les agriculteurs d’autre part, les premiers n’ont pas besoin de remettre en cause leurs évaluations et les seconds leurs pratiques. Cela crée donc une forme d’ignorance, qui est profitable à l’Anses car changer les normes prend du temps est coûteux, alors que les agences ont généralement peu de moyens et sont en retard dans leurs évaluations.

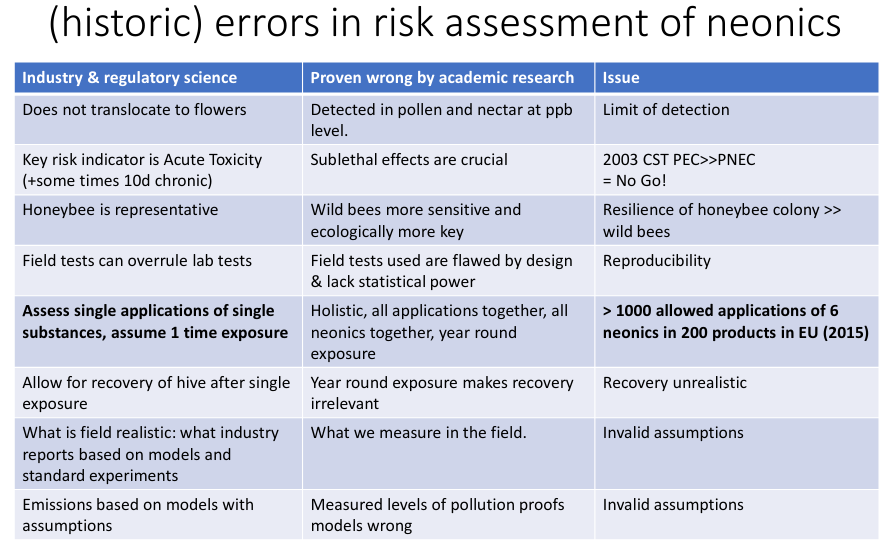

Les néonicotinoïdes, un exemple de la faillite des agences

Les néonicotinoïdes fournissent un exemple marquant de faillite des agences. Malgré une alerte précoce sur les effets néfaste des ces substances, il a fallu attendre plus de vingt ans pour qu’elles soient (partiellement) interdites. Le chercheur Jeroen van der Sluijs résume certaine erreurs des agences ayant conduit à ces décisions désastreuses sur le plan écologique : minimisation de la contamination, concentration sur les effets aigus, études restreintes à l’abeille domestique, évaluation des effets sur une seule application d’une seule substance, etc.

Des critiques peu prises en compte par les agences

Les critiques énoncées précédemment ne sont pas nouvelles. Le sociologue François Dedieu s’est intéressé à la manière dont les agences prennent en compte ces critiques. Son constat est que ces critiques n’arrivent pas à entraîner une remise en cause des pratiques des agences. Il affirme également que certaines ONG et groupes anti-pesticides ont tendance à épargner les méthodologies des agences, en se concentrant sur les conflits d’intérêt. Certaines ONG sont également dans les instances administratives ou dirigeantes des agences, ce qui les place paradoxalement en situation de conflit d’intérêt pour critiquer ces mêmes agences. Cela a alors pour effet d’étouffer les voix contestataires.

Lorsque des connaissances sont mises en avant, qui pourraient mettre en cause les méthodologies des agences (comme, par exemple, la surestimation de l’efficacité des équipements de protection), elles sont réinterprétées afin de rester en cohérence avec les règles d’évaluation des risques. D’une certaine manière, les agences n’ont jamais tort. Dedieu fait un parallèle avec la dissonance cognitive : devant des connaissances inconfortables qui mettent en cause la capacité des agences à contrôler les différents dangers potentiels, celles-ci tentent de présenter ces connaissances comme cohérentes avec les règles.

Par exemple, sur les équipements de protection, les scénarios d’exposition utilisés par les agences étaient critiqués, données à l’appui. Jusque-là, ils étaient considérés comme robustes car jamais remis en cause… faute de données. Cela place bien le travail des agences en dehors d’un travail scientifique, où les scénarios ne sont plus confrontés à des données réelles. Cette non confrontation au réel s’explique aussi par le secret qu’entretiennent les agriculteurs sur leurs traitements, comme indiqué précédemment.

Suite à la médiatisation du cas du glyphosate, l’Esco souligne que les règlements européens ont été modifiés pour faire preuve de plus de transparence et limiter les conflits d’intérêt. Si ces changements sont salutaires, ils ne répondent en rien à l’ensemble des limites mentionnées précédemment. On est bien dans ce que décrit Dedieu : les critiques sont entendues mais n’entrainent pas de changement fondamental du processus d’homologation.

Finalement, les agences et l’agro-industrie se trouvent sur un terrain d’entente dans la non remise en cause des processus d’homologation. Pour l’industrie, ce serait un processus long et coûteux, qui pourrait lui demander d’avantage d’études pour voir un produit homologué ; pour les agences, cela complexifierait le processus d’homologation alors qu’elles ont déjà du retard dans le traitement des dossiers.

Des agences pour autoriser les produits et limiter certains risques

Fondamentalement, le rôle de ces agences est d’autoriser les produits en limitant certains risques. Le présupposé qui régit ces agences est que toute substance est bonne à être autorisée, quelque soit son utilisation, leur rôle étant d’établir les seuils limite d’exposition autorisés sur la base des études produites par les industriels (avec toutes les limites mentionnées avant). Comme le souligne Boudia et Jas, cela dépolitise le rôle des agences, alors qu’évidemment le présupposé régissant les agences est éminemment politique. De plus, ce rôle, d’après Henry, conduit à légitimer l’exposition à des risques du moment que l’exposition se fait en dessous de certains seuils considérés comme acceptables (mais amenés à évoluer). Or, Henry nous indique que plus d’un tiers des dossiers des produits chimiques les plus utilisés sont incomplets. Les seuils sont donc établis sur la base de données parcellaires obtenues dans le cadre d’une réglementation parcellaire.

Il n’est donc pas étonnant que les premières alertes, qu’elles portent par exemple sur des perturbateurs endocriniens, sur l’atrazine, le bisphénol A, le glyphosate, les néonicotinoïdes ou le chlorpyrifos ne soient pas issues des données réglementaires demandées par les agences, ni de leurs analyses mais d’études académiques, hors cadre réglementaire. L’Esco le souligne : il faut parfois plus de dix ans pour que les connaissances scientifiques soient prises en compte dans l’évaluation des risques.

Or, les agences s’attachent à fréquemment ignorer ces données académiques inconfortables, notamment car elles ne respectent pas les « bonnes pratiques de laboratoire » qu’elles n’ont pas à respecter. Si le premier souci de ces agences est la santé des populations, est-il raisonnable d’ignorer des connaissances qui ont été à l’origine d’alertes pertinentes sur des substances variées ? C’est une autre illustration de ce que pointait Dedieu ou Boudia et Jas : le rôle des agences réglementaires est également économique en autorisant des substances que des industriels jugent utiles (ce qu’illustre également le fait que l’OCDE a mis en place un certain nombre de règles désormais suivies par les agences, afin de faciliter le travail des industries). On part du principe que les avantages dépassent forcément les inconvénients, sans réelle évaluation des uns et des autres et en identifiant encore moins qui bénéficie des avantages et qui en subit les inconvénients. Pour Henry, cette ignorance est en fait consubstantielle de la réglementation des produits chimiques, c’est justement une telle ignorance qui les rend administrables. Sans cela, la régulation des produits serait plus complexe, plus longue, plus coûteuse et il ne serait possible que d’homologuer beaucoup moins de produits, ou d’augmenter drastiquement les moyens des agences. Le fonctionnement des agences est donc bien régi et dépendant de contraintes politiques. Présenter ces agences comme scientifique est donc une erreur fondamentale qui oublie tous ces aspects.

Dans ces conditions, affirmer que toute exposition à des doses inférieures aux seuils établis par les agences est sans risque semble bien audacieux tant les trous dans la raquette des agences sont nombreux.

Sources principales

Boudia et Jas (2019) : « Gouverner un monde toxique »

Dedieu (2021) : « Organized denial at work: The difficult search for consistencies in French pesticide regulation »

Demortain (2021) : « The science behind the ban: the outstanding impact of ecotoxicological research on the regulation of neonicotinoids »

Elliott (2022) : « Addressing Industry-Funded Research with Criteria for Objectivity »

Expertise collective INRAE-Ifremer (2022) : « Biodiversité et services rendus par la nature : que sait-on de l’impact des pesticides ? »

Henry (2021) : « La fabrique des non-problèmes »

Horel (2022) : « Pesticides : la grande illusion des équipements de protection des agriculteurs »

Huc et Barouki (2021) : « Réglementation des substances chimiques : science et décision, lenteur et confusion »

Huc et Jouzel (2021) : « L’évaluation des risques des pesticides : entre savoir réglementaire et science académique »

Kleinman et Suryanarayanan (2013) : « Dying Bees and the Social Production of Ignorance »

Morais-Rocha et Koppe-Grisolla (2018) : « Why pesticides with mutagenic, carcinogenic and reproductive risks are registered in Brazil »

Sgolastra et al (2021) : « Bees and pesticide regulation: Lessons from the neonicotinoid experience »

Siviter et Muth (2021) : « Do novel insecticides pose a threat to beneficial insects? »

Mises à jour

- 6 juillet 2023 : Rectification d’une citation déformée de l’expertise collective Inrae/Ifremer (« une partie des connaissances scientifiques faisant partie du champ académique sont écartées du processus réglementaire » au lieu de mentionner « les contraintes qui conduisent à écarter du processus décisionnel une partie des connaissances scientifiques pourtant disponibles dans le champ académique. »)

- « There is even an implicit arrangement between the anti- and the pro-pesticide coalitions that seem a priori to be totally at odds with each other. By focusing its criticism on regulatory capture, and sparing regulatory science, the anti-pesticide coalition indirectly serves the interests of the pro-pesticides. » [↩]

- « Comme pour le BPA, le BPS se lie aux RE [récepteurs œstrogéniques] [134]. Plusieurs analogues, dont le BPS, le BPE, le BPF et le BPB, se lient aux RE et aux récepteurs des androgènes » (p.59 [↩]

- « En effet, un des critères, qui est celui du lien de causalité entre la perturbation des hormones et l’effet toxique, est particulièrement difficile à remplir : en effet, les effets toxiques n’apparaissent souvent que longtemps après l’exposition, rendant le lien causal difficile à documenter. Par ailleurs, nous manquons souvent d’une évaluation fiable de l’exposition. Il est donc impératif, pour une bonne gestion, de pouvoir s’intéresser à des substances qui seraient des PE suspectés ou présumés, donc avec des niveaux de preuve inférieurs à ceux des PE avérés. » [↩]

- « Current regulations of man-made chemicals systematically underestimate health risks

associated with combined exposures to EDCs or potential EDCs. » (p.17) et « When assessing language delay and birth weight endpoints, we found that the current single compound approaches underestimated risk by a factor that ranged from 1 to 100 for different chemicals » (p.12) [↩] - « Les résultats de ces tests sont assortis de facteurs de sécurité pour prendre en compte la différence de sensibilité entre individus et espèces. Ils sont parfois considérés comme sur-protecteurs du fait du manque de réalisme des degrés d’exposition et de sensibilité envisagés, mais ils sont aussi parfois considérés comme insuffisamment protecteurs car ne tenant pas compte de la diversité des espèces présentes et de leurs interactions. » [↩]

- Dans le texte : « exposure scenarios are robust because they are never challenged » (p.5) [↩]

Ces agences cherchent à produire de la certitude : la certitude que les produits qu’elles analysent ne causent aucun dommage.

Alors que les marchands de doute essaient de mettre du doute dans des débats que la science a déjà tranchés.

Bonjour,

Faire croire à une méthodologie scientifique, alors qu’il ne s’agit que d’un empoisonnement de masse et de classe.

C’est justement ce qu’a révélé l’affaire Fakir et la manipulation de l’information sur le glyphosate et le dénigrement du CIRC par Avisa Partners :

https://www.blast-info.fr/emissions/2022/lobbying-manipulations-de-linfo-revelations-dun-journaliste-independant–ED6ZgqwTu6qgsWW5ZwsSw

Lire ici pour avoir la liste des clients de cette entreprise « d’intelligence économique »:

https://twitter.com/tristanwaleckx/status/1552049410779107328

Il ne reste plus qu’à recruter des zététitiens i-stratés pour colporter ces informations.

Le livre référence en matière de Marchands de doutes avait déjà débusqué cette imposture qui consiste à habiller de science ce qui n’est qu’une vision politique :

https://www.editions-lepommier.fr/les-marchands-de-doute-1

L’affaire Avisa est quand même de nature différente (influence via de faux médias), là où les agences produisent en partie d’elles-mêmes de l’ignorance.

Mais oui, très bonne référence Les marchands de doute !

Bonjour,

Ce n’est malheureusement pas de nature différente.

Les agences sanitaires sont en fait mal nommées mais c’est un classique tout à fait orwellien : agences du «business as usual» serait certainement plus approprié.

Le message subliminal délivré par le Directeur de notre agence nationale lors de son entretien à Rivière-Wekstein fût un excellent marqueur de l’état d’esprit, lire l’article « https://charliehebdo.fr/2018/09/politique/roger-genet-president-de-lanses-demission%E2%80%89-la-peau-de-roger-genet/ ». Mais le plus grave est que cette intervention n’ait suscité aucune émotion ni en interne (certains membres du comité de déontologie ont bien démissionné plus tard mais pour un autre motif) ni dans la classe politique. La connivence est totale (ce qu’explique bien le documentaire de Blast).

Plus personne n’est dupe sur le fait que les bases réglementaires utilisées par les agences ont été sorties d’un chapeau dans les années 50 (Lire l’ article « https://blog.m2rfilms.com/conference-inaugurale-du-colloque-medical-suisse-quadrimed/ » ou cet autre article « https://vif-fragiles.org/la-sante-environnementale-a-la-tres-grande-peine/ »). Essayer de faire coller la science avec ces anciens postulats est de plus en plus délicat car des expériences scientifiques s’en éloignent tous les jours un peu plus. Cela peut effectivement porter à confusion avec une stratégie de Marchand de doutes.

Pour les pesticides, les écarts sont encore plus criants : l’évaluation principale porte sur la matière active et non pas sur le produit qui va être vendu aux agriculteurs et qui va se retrouver finalement dans l’environnement ou l’assiette du consommateur, comme le décrit ce podcast «https://www.youtube.com/watch?v=0_Qf87qJWP4 ». Pourtant le débat a été polarisé (sciemment sûrement) sur cette dernière alors que les Monsanto papers montraient clairement que cette approche était inadéquate dans le cas du RoundUp (dont le glyphosate est un composant mais peut être pas le plus dangereux).

L’essentiel, au moins aux yeux de notre classe politique et de ceux qui les mettent au pouvoir (je ne parle pas ici des électeurs), demeure cependant de rester dans le Marché mondial et de ne pas imposer des normes qui se retourneraient contre notre capacité à commercer avec des pays tiers. On se contente donc de signer des traités internationaux avec des normes « science based » du XXe siècle et les règles sanitaires a minima de l’OCDE. Aux États-Unis on cultive un potager bio à la Maison Blanche mais on laisse les communautés hispaniques exposées aux pesticides comme l’a montré cette étude décrite dans cet article « https://www.ewg.org/news-insights/news-release/2022/09/study-communities-color-greatest-risk-pesticide-exposure-ventura ».

Procrastiner, implorer la science et la raison, rassurer, dédramatiser, maintenir les dégâts sous le radar grâce à la main mise sur les médias, se servir au passage si possible, mentir si nécessaire, manger bio si les capacités de discernement le permettent encore mais surtout ne rien changer. Voilà l’objectif inavoué.